PLM-Systeme sollen der Backbone für die Datenverteilung im Unternehmen sein. Was in einem kleinen oder mittelständischen Unternehmen mit sauber strukturierter IT-Landschaft noch umsetzbar ist, wird in Großunternehmen, beispielsweise aus dem Automotive-Bereich zum Alptraum. Mehrere hundert Tools müssen angebunden werden und miteinander Daten austauschen können. Prof. Martin Eigner, Leiter des Lehrstuhls für Virtuelle Produktentwicklung (VPE) der TU Kaiserslautern, erläutert im Interview Alternativen zu diesem Ansatz. Anlass für das Interview war die Meldung, dass Autohersteller GM das PLM-System von Aras als Plattform für alle Marken weltweit einsetzen wird.

Herr Prof. Eigner, wie ist denn der Status in der Automobilindustrie?

Die Automobilindustrie steht vor großen Herausforderungen, die Zukunft mit Car Sharing, E-Autos und Autonomem Fahren wird die Branche stark verändern. Die Unternehmen reagieren darauf unter anderem mit der Optimierung und Straffung ihrer Prozesse. Dabei spielen PLM-Systeme, die den Lebenszyklus des Produkts von der Konzeption bis zum Service begleiten, eine Schlüsselrolle.

Wo liegt dabei die Herausforderung, etwa im Vergleich mit kleineren Unternehmen?

Bei einem deutschen Automobilbauer sind typischerweise zwischen 300 und 500 fragmentierte Systeme im Einsatz, vom Requirements Management über CAD bis hin zu Systemen für die Produktionssteuerung und den Service. Der Versuch, diese Systeme durch PLM zu verbinden, ist gescheitert – es existiert in Wirklichkeit kein Backbone, der alle Daten vereint.

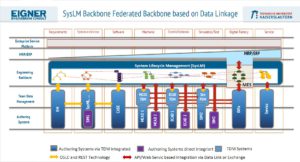

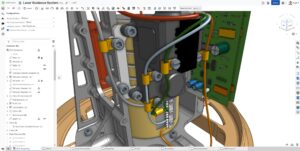

Die Idee der PLM-Anbieter ist, dass die Autorensysteme, also die Anwendungen, in denen Daten erzeugt werden, beispielsweise CAD – ihre Daten nach oben an den Backbone liefern, dort mit anderen Daten verknüpft und wieder abrufbar sind. Stand heute würden die bestehenden Systeme diesen Datenfluss gar nicht verkraften, der Backbone würde platzen.

Und wie kann die Alternative aussehen?

Die Gartner Group hat das Konzept „bimodale IT-Systeme“ vorgestellt, sozusagen eine IT der zwei Geschwindigkeiten. Daten werden hier nicht über eine Schnittstelle in eine Datenbank überführt, sondern über leichtgewichtige, moderne APIs wie REST verlinkt. Die Systeme greifen über ein Repository, in dem alle Daten aller Systeme referenziert sind, auf die Daten anderer Systeme zu. So bleiben die Daten in ihrem jeweiligen Kontext., können aber auch von außen genutzt werden. So ist es nicht mehr notwendig, 300 bis 500 Schnittstellen und die Semantik zu entwickeln, die es Systemen ermöglicht, die Daten anderer Systeme zu verstehen. Da das Repository objektorientiert ist, erben die daran angeschlossenen Systeme nicht nur die Datenobjekte, sondern auch die Funktionen, die hier implementiert sind. Die Gartner Group hat neben Aras das CAD-System Onshape und das PLM-System Propel als Beispiele bimodaler Systeme identifiziert.

In einem Beitrag für Aras habe ich die Merkmale bimodaler Systeme zusammengefasst:

- Von Dokument-basiert zu Modell-basiert.

- Von hierarchischen- (herkömmlichen Stücklisten der Hardware) bis hin zu Netzwerk- (MBSE) und linearen Strukturen (Software).

- Aufteilung der Anwendungsdaten und Metadaten auf Basis eines objektorientierten Repository.

- Von monolithischen zu föderierten und leichtgewichtigen Systemen, die auf referenzierte bzw. verknüpften Daten. Die dazu notwendigen IT-Technologien basieren auf dem objektorientierten Repository und/oder REST.

- Bereitstellung auf unterschiedlichen Cloud-Level (IaaS, PaaS und SaaS[2])

- Unterstützung der typischen Engineering Prozesse wie z.B. Engineering Change Management (ECM) und Configuration Management (CM) für Mechanik, Elektrik / Elektronik und Software.

- Agile Einführung und betriebliche Anpassung durch überwiegend interaktive Konfiguration anstatt durch prozedurales Customizing.

- Automatischer Übernahme aller betrieblicher Anpassungen (Konfiguration und Customizing!) bei Upgrade des Basissystems.

- Neue flexible Geschäftsmodelle auf Basis von Subscriptions anstatt Lizenzen.

Die letzten drei Punkte deuten darauf hin, dass die Implementierung einfacher und preiswerter zu sein scheint als bei den typischen PLM-Systemen. Bisher war je die Einführung eines PLM-System mit hohen Investitionen in Customizing verbunden.

Das ist bei bimodalen Systemen anders, da hochkomplexe Vernetzungen mit anderen Systemen und schwierige Datenmigrationen eben nicht notwendig sind. Bei normalen PLM-Systemen rechnet man mit einem Customizingaufwand, dessen Kosten in einer Größenordnung zwischen der Höhe der Lizenzkosten bis zu den dreifachen Kosten wie für die Lizenzen liegen. Bei Aras liegt der Customizingaufwand weit niedriger, wir haben bei typischen Customizing-Usecases an meinem Lehrstuhl bei modalen PLM-Systemen einen bis zu dreifach höheren Aufwand gemessen.

Vor allem aber muss normalerweise mit jedem Versionswechsel das Customizing angepasst beziehungsweise neu erstellt werden, was wieder hohe Kosten nach sich zieht. Aras garantiert dagegen die Aufwärtskompatibilität sämtlicher Anpassungen, so dass ein Versionswechsel keine weiteren Kosten nach sich zieht.

Und das Thema Subscription? Steigert das nicht die Kosten über die Jahre?

Wenn man richtig rechnet, nein. Die Subscription kostet in etwa 20 Prozent des Preises, den der Kauf einer Lizenz kosten würde. In fünf Jahren zahlt man also den kompletten Preis einer Lizenz, vermeidet aber zum einen das hohe Anfangsinvestment in den Lizenzkauf. Zum anderen erhält man jederzeit die aktuellste Version, ohne Upgradegebühren zu zahlen, und vermeidet dank der Kompatibilitätsgarantie von Aras die Customizingkosten, die ansonsten anfallen. Am Ende rechnet sich das.

Herr Eigner, vielen Dank für das Gespräch.

Bei allem Respekt für Martin Eigner, es gibt m.E. keine bimodalen PLM-Systeme, sondern allenfalls PLM-Systeme, die sich für eine agile Implementierung im Rahmen einer bimodalen IT-Strategie besser eignen als andere. Lesen Sie dazu meinen aktellen Blog-Beitrag:

http://www.wendenburg.net/plm-blog/bimodale-plm-systeme-zukunft-oder-marketinggag/?page=0

Lieber Michael,

„bei allem Respekt“ bin ich doch von Dir gewohnt, dass Du sorgfältiger recherchierst. Zunächst einige Richtigstellungen:

– Ich habe nicht für ein einzelnes System die Bimodalität reklamiert, sondern die Aussage von Marc Halpern übernommen, dass Propel, Onshape und Aras bimodale Systeme sind.

– Natürlich spreche ich von einer gesamten Infrastruktur (wie das im Blog herangezogene Bild zeigt), die aber von dem förderierten Engineering Backbone semantisch verknüpft werden. Dazu werden Technologien wie objektorientiertes Repository und REST zur Verlinkung eingesetzt.

– Ich halte weiterhin die Definition von Gartner für richtig, die eine zweigeteilte Implementierung propagiert: z.B. Wasserfall bei Modalität und agile Techniken bei bimodalen Systemen. Ich werde Dir dazu einen Beitrag von Microsoft zusenden, die darin bewiesen haben, dass mit dem

durch die Repository Technik extrem vereinfachten interaktiven Customizing eine agile PLM Implementierung möglich und sinnvoll ist.

– GM setzt Teamcenter als TDM System zur Verwaltung von CAD Daten ein. Dies wird auch in Zukunft so bleiben. Aras liegt als verlinkter Backbone über den fragmentierten Engineering Applikationen. Dies entspricht auch dem Implementierungs-konzept von Schaeffler.

Die drei oben genannten bimodalen Systemen sind nicht über Nacht bimodal geworden. Sie wurden mit den Zielen der Förderation, Verlinkung, Flexubilität, Agilität und des einfachen Customizing entwickelt. Der Begriff bimodal ist über Nacht enstanden und hat diese Entwicklungen in diesem Begriff zusammengefasst, wie auch ähnliche Begriffe wie Digitales PLM (Accenture) oder System Lifecycle Management (Sendler und Eigner). Ob das nun eine bimodale Implementierung ist oder ein bimodales System ist zweitrangig .

Deine Bemerkung bzgl. eines Marketinggags kann man auch positiv sehen. Natürlich ist bimodal genauso wie Industrie 4.0 ein Buzzword. Aber wir beide wissen doch aus langjähriger Erfahrung, dass die überwiegenden PLM Einführungen auf der Ebene eines CAD-Verwaltungssystemes endeten. Also als Tiger gesprungen und als Bettvorleger gelandet…..Und wenn ein Buzzword sauber definiert in der Lage ist die PLM Community aufzurütteln um dem Milliardengrab PLM eine Alternative gegenüberzustellen, finde ich es gut eingesetzt.

Und noch etwas: Wir beide waren an dem Thesenpapier PLM Future beteiligt (damals gabe es allerdings auch noch nicht den Begriff Bimodalität). Ich zitiere daraus:

a) „Es gibt nicht DEN digitalen Master – Kern eines zukünftigen PLM-Ansatzes ist die Aggregation und Verlinkung von verteilten Daten zu einem digitalen Master, d.h. eine durchgängige digitale Produktbeschreibung mit Daten aus Entwicklung, Fertigung und Betrieb. Dieser digitale Master muss schrittweise und föderativ aufgebaut werden und unterliegt einem ständigen Veränderungsprozess.“ und

b) „Monolithische Systeme haben ausgedient – Monolithische Lösungen sind vor dem Hintergrund der gestiegenen Produkt- und Prozess-komplexität nicht mehr adäquat. Es gibt auch nicht das EINE System für alle Prozesse und Beteiligten im Produktlebenszyklus. Wir brauchen föderierte semantische Netzwerke, welche die auf verschiedene Subsysteme verteilten digitalen Modelle verknüpfen.“

Jetzt frage ich Dich, was ist in dem Blog anderes ausgesagt als in diesen komprimierten Thesen.

Mit den besten Grüßen und vorwärts mit einfacheren und leichtgängigen PLM Implementierungen in der Zukumft – eben bimodal (:-)

Martin (Eigner)

Bitte lesen Sie meinen Kommentar unter http://www.wendenburg.net/plm-blog/bimodale-plm-systeme-zukunft-oder-marketinggag/?page=0

Mit besten Grüßen

Martin Eigner